I. Introducción

Numerosos fabricantes de automóviles y empresas de tecnología están desarrollando sistemas de conducción automatizados. Cada año estas empresas salen con nuevas tecnologías que buscan reducir el “factor humano” en la conducción. Todas estas empresas comparten el mismo objetivo: vehículos totalmente autónomos (AV).

Según el informe anual de 2018 de la Administración Nacional de Seguridad del Tráfico en las Carreteras, aproximadamente 37,000 personas murieron en colisiones de vehículos motorizados ese año y otros 2.7 millones resultaron heridas. El Departamento de Transporte de los Estados Unidos estima que el error humano representó el 94% de estos accidentes. Estas estadísticas son ampliamente citadas por los defensores de la tecnología AV, y es fácil respaldar una causa que puede eliminar el 94% de las lesiones y muertes innecesarias. Sin embargo, junto con los beneficios potenciales, también se pueden percibir los problemas inevitables, especialmente en el sector legal. ¿Cómo regulamos los AV? ¿Quién tendrá la culpa en caso de colisión? ¿Cómo recuperará una parte lesionada sus daños?

II. Niveles de automatización

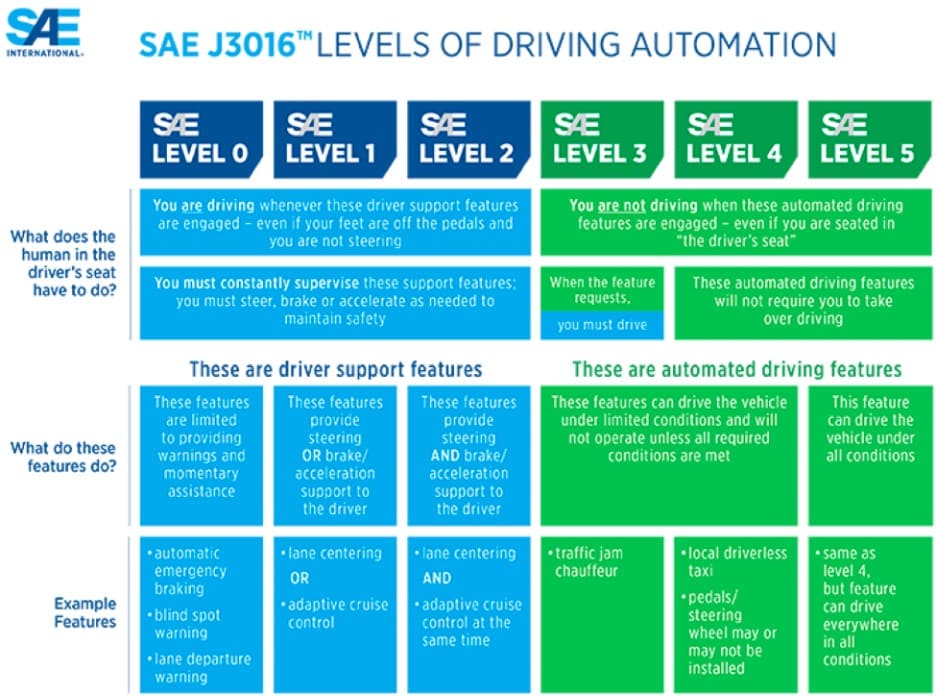

El Departamento de Transporte de EE. UU. adoptó la clasificación de seis niveles de automatización de la conducción de la Sociedad de Ingenieros Automotrices (SAE). Este esquema de clasificación es actualmente aceptado en todo el gobierno y las industrias.

Como se describe a continuación,1 La “conducción automatizada” (niveles SAE 3-5) son vehículos que no requieren intervención humana para operar de manera segura. Algunos ejemplos incluyen robotaxis, autobuses automatizados, camiones automatizados y vehículos autónomos de uso personal. Actualmente se están desarrollando vehículos que califican como Nivel 4, pero aún no están disponibles para el público en general.

Los vehículos de “conducción manual” (niveles SAE 0-2) están actualmente disponibles para el público en general. Los niveles SAE 0-2 no son completamente autónomos y requieren que un conductor humano supervise el entorno de conducción y esté listo para tomar el control en cualquier momento para garantizar la seguridad.2 Los vehículos manuales más avanzados (Nivel 2) están equipados con sistemas de asistencia al conductor que permiten que el vehículo controle la dirección y el frenado / aceleración simultáneamente sin intervención humana. Estas tecnologías incluyen frenado automático de emergencia, control de crucero adaptativo, mantenimiento de carril y "piloto automático" limitado.

Existe una idea errónea generalizada sobre la tecnología AV disponible actualmente. Esto se debe en parte a la publicidad corporativa. Probablemente el fabricante más conocido de la industria, Tesla, afirmó en un comunicado de prensa en 2018 que todos sus vehículos estaban equipados con tecnología para hacerlos "autónomos" y "son más seguros que los conductores humanos".

Sin embargo, la tecnología de piloto automático de Tesla requiere control humano (Nivel 2). Como se analiza a continuación, este malentendido de la tecnología dio lugar a una demanda colectiva contra Tesla. También se alegó “tergiversación” corporativa en un litigio relacionado con dos muertes en vehículos de motor que involucraban un vehículo Tesla.

Consejo práctico: Identificar el nivel de automatización es importante a la hora de evaluar la responsabilidad y determinar qué reclamaciones legales presentar. Sin embargo, el sistema de clasificación SAE de seis niveles puede confundir al jurado. Puede ser más sencillo enmarcar la discusión como “Conducción manual” (Niveles 0-2) versus “Conducción automatizada” (Niveles SAE 3-5).

III. Incidentes y litigios audiovisuales

No ha habido un litigio significativo en torno a AV, y el litigio existente está en su infancia. Lo que sigue son resúmenes de algunos de los incidentes y litigios que localizamos en todo el país relacionados con AV.

El 29 de junio de 2016, Josh Brown murió cuando su vehículo Tesla que operaba en piloto automático chocó con un camión blanco en Williston, Florida.3 Esta fue la primera muerte en Estados Unidos que involucró a un vehículo que operaba con funciones autónomas activadas. El piloto automático de Tesla no detectó el camión blanco que "cruzaba la carretera perpendicular al Model S" antes del accidente. Tesla admitió que "ni el piloto automático ni el conductor notaron el lado blanco del remolque del tractor contra un cielo brillantemente iluminado, por lo que no se aplicó el freno". La Junta Nacional de Seguridad del Tráfico (NTSB, por sus siglas en inglés) concluyó que la causa probable del accidente fue "la incapacidad del conductor del camión de ceder el paso y la falta de atención del conductor del automóvil". Es importante destacar que la NTSB también concluyó que el patrón de uso del sistema de piloto automático del Sr. Brown mostraba una "dependencia excesiva de la automatización y falta de comprensión de las limitaciones del sistema".4

In Nilsson contra General Motors LLCNilsson resultó herido cuando un Chevrolet Bolt “autónomo” cambió repentinamente de carril y chocó con su motocicleta.5 Había un conductor humano en el Bolt en el momento de la colisión, pero no tenía las manos en el volante mientras estaba activado el modo autónomo. El 22 de enero de 2018, Nilsson presentó una denuncia en un tribunal federal de California alegando negligencia de General Motors. La reclamación se resolvió seis meses después por un monto no revelado.

In Hudson contra Tesla, Inc., Hudson alegó que su Tesla Model S 2017 no detectó la presencia de un vehículo averiado en la carretera, lo que provocó una colisión a aproximadamente 80 millas por hora.6 Hudson presentó los siguientes cargos contra Tesla: (1) responsabilidad estricta; (2) negligencia; (3) incumplimiento de la garantía implícita de idoneidad; (4) tergiversación; (5) publicidad engañosa; y (6) prácticas comerciales desleales y engañosas. Hudson también alegó negligencia contra el propietario del vehículo abandonado.

El 18 de marzo de 2018, ocurrió una colisión fatal de un vehículo motorizado en Tempe, Arizona, que involucró a un vehículo Uber autónomo. El vehículo Uber estaba equipado con un "sistema de detección" y estaba en modo autónomo con un conductor humano cuando chocó contra Elaine Herzberg.7 La NTSB concluyó que el SUV de Uber no podía determinar si Herzberg era un peatón, un vehículo o una bicicleta, y tampoco pudo predecir correctamente su camino. Específicamente, "el diseño del sistema no incluyó una consideración para los peatones que cruzan imprudentemente".8 1.2 segundos antes de la colisión, el sistema identificó a Herzberg como una bicicleta que se interponía en el camino del Uber, pero ya era demasiado tarde para frenar o evitar una colisión. Curiosamente, en 2015, el gobernador de Arizona, Doug Ducey, utilizó una orden ejecutiva para declarar a Arizona una zona AV libre de regulaciones con el fin de atraer operaciones de prueba de empresas como Uber.9

In Lommatzsch contra Tesla, Inc., Lommatzsch había activado el piloto automático de su Tesla Model S cuando el automóvil chocó contra otro vehículo a 60 mph.10 Lommatzsch alegó que el personal de ventas de Tesla le aseguró que el Model S "se detendría por sí solo en caso de que hubiera un obstáculo en el camino del Tesla Model S". Según la demanda, Tesla fue “negligente al desarrollar, diseñar, fabricar, producir, probar, promover, distribuir, vender, mantener, reparar y/o dar servicio al Tesla Model S, y/o al proporcionar advertencias adecuadas sobre los peligros del Tesla Model S”. Tesla Modelo S.”

El 24 de mayo de 2018, Tesla resolvió una demanda colectiva con los compradores de sus autos Model S y Model X que alegaron que el sistema de piloto automático de la compañía era "esencialmente inutilizable y demostrablemente peligroso".11 Los demandantes argumentaron que se convirtieron en "probadores beta de software a medias que hace que los vehículos Tesla sean peligrosos", y que cuando el piloto automático está activado, es susceptible de "dar bandazos, pisar los frenos sin motivo alguno y no reducir la velocidad o detenerse al acercarse" otros vehículos."

In Huang y otros, contra Tesla, Inc., el patrimonio de Wei Huang demandó a Tesla después de que el Tesla de Huang chocara contra una mediana de concreto mientras estaba en piloto automático, causando su muerte en marzo de 2018.12 Los reclamos de Huang contra Tesla incluían negligencia, muerte por negligencia, responsabilidad estricta, negligencia (posventa), diseño de producto defectuoso, falta de advertencia, tergiversación intencional y negligente y publicidad falsa.

El 1 de marzo de 2019, Jeremy Banner murió cuando chocó con un camión con remolque en Florida. Los datos preliminares del vehículo mostraron que el sistema de piloto automático de su Tesla se activó aproximadamente 10 segundos antes de la colisión, que ni Banner ni el piloto automático redujeron la velocidad del automóvil ni intentaron ninguna maniobra evasiva y que el vehículo no detectó las manos del conductor en el volante.13 El patrimonio de Banner alegó publicidad falsa del Modelo 2018 de 3. El anuncio en cuestión decía que “si ha comprado el paquete opcional de piloto automático mejorado o capacidad de conducción autónoma completa, las cámaras orientadas al futuro y el sensor de radar están diseñados para determinar cuándo hay un vehículo delante de usted en el mismo carril. Si el área frente al Model 3 está despejada, el control de crucero consciente del tráfico mantiene una velocidad de conducción establecida. Cuando se detecta un vehículo, el control de crucero consciente del tráfico está diseñado para reducir la velocidad del Model 3 según sea necesario para mantener una distancia cronometrada seleccionada desde el vehículo de adelante, hasta la velocidad establecida ".14

Consejo práctico: La información almacenada electrónicamente (ESI) es un componente clave en cada demanda antivirus. Es extremadamente importante preservar el vehículo y todas las formas de ESI, incluso desde dispositivos periféricos, como teléfonos móviles y portátiles. Prácticamente todos los incidentes mencionados anteriormente incluyeron ESI. En la colisión de Herzberg, ESI incluyó datos del automóvil, así como un video de la cámara del tablero que muestra al conductor mirando repetidamente hacia su regazo. En la colisión de Banner, ESI confirmó que Banner activó el piloto automático segundos antes del choque y el vehículo no detectó las manos de Banner en el volante. En la colisión de Brown, ESI detectó un patrón en el conductor mientras estaba en piloto automático, lo que respaldó la conclusión de la NTSB de que no entendía completamente la tecnología.

IV. Legislación sobre AV

A medida que continúen los avances tecnológicos, también lo harán la legislación y las normas regulatorias. Si bien el gobierno federal es responsable de establecer las normas de seguridad de los vehículos motorizados, los estados siguen siendo el organismo regulador de las licencias, el registro, la aplicación de la ley, los seguros y la responsabilidad.

Numerosos estados han promulgado leyes sobre AV. Generalmente, estas leyes se refieren a la automatización de vehículos en los Niveles 3 y 4 e implican requisitos de licencia que incluyen una mayor cobertura de seguro de responsabilidad. Además, los gobernadores de 11 estados15 han emitido órdenes ejecutivas relacionadas con vehículos autónomos. Montana no tiene actualmente ningún tipo de regulación AV.

El Congreso también propuso varios marcos regulatorios, incluida la Ley de Implementación e Investigación Futuras de la Evolución de los Vehículos (AUTO DRIVE) que Aseguran Vidas Seguramente en la Cámara, y la Ley de Visión Estadounidense para un Transporte Más Seguro a través del Avance de Tecnologías Revolucionarias (AV START) en el Senado. Sin embargo, tanto la Ley AUTO DRIVE como la Ley AV START se estancaron en el Senado en 2018. Parece que existe un apoyo bipartidista continuo para la legislación AV. Esto incluye el establecimiento de un "Consejo Asesor de Vehículos Altamente Automatizados" dentro del Departamento de Transporte ("DOT") para evaluar problemas relacionados con AV y abordar la regulación federal de pruebas AV.

El 23 de marzo de 2018, el presidente Trump promulgó la Ley de Asignaciones Consolidadas (Proyecto de Ley Ómnibus 2018). Esta legislación, entre otras cosas, ordena al DOT que lleve a cabo investigaciones sobre el desarrollo de AV. El 16 de abril de 2020, el DOT y la Oficina de Ciencia y Tecnología de la Casa Blanca publicaron el Garantizar el liderazgo estadounidense en tecnologías de vehículos automatizados: vehículos automatizados 4.0, que proporciona recomendaciones para la legislación estatal.

V. Marco Legal

No está claro cómo se desarrollará el litigio AV. ¿Quién será responsable de la “negligencia” de un automóvil? ¿El fabricante de automóviles? ¿El fabricante de los componentes de la automatización, como sensores, cámaras o sistemas de navegación? ¿La persona que estaba en el asiento del conductor pero que en realidad no conducía? ¿Los tres? ¿Habrá limitaciones legales y/o reclamaciones?

Existen varias teorías sobre cómo los tribunales deberían abordar la responsabilidad AV. David King propone hacer una analogía de la responsabilidad AV con la forma en que los tribunales manejan los accidentes relacionados con el transporte equino. Tanto los caballos como los vehículos autónomos pueden percibir su entorno, malinterpretarlo y realizar maniobras peligrosas independientemente de la voluntad de su operador humano.16

Por ejemplo, en Alpha Construction contra Brannon, 337 SW2d 790 (Ky. 1960), un caballo que caminaba al costado de una carretera fue sorprendido por un fuerte ruido y galopó hacia la calle, provocando un accidente. En comparación, en la muerte de Tesla de 2016 discutida anteriormente, el AV “vio” un camión blanco contra un cielo brillante, pensó que no era peligroso y se dirigió directamente hacia el camión. Las maniobras resultantes en ambas circunstancias fueron causadas por una falta de comprensión del entorno. Además, tanto los caballos como los vehículos autónomos son propiedad de consumidores habituales que pueden prestarlos a otros y son operados por ellos.

Otra teoría alienta a los legisladores a adoptar un estándar de responsabilidad estricta contra la industria por accidentes que involucren AV basado en la doctrina de los instrumentos peligrosos. Los defensores argumentan que los vehículos autónomos son más peligrosos que los automóviles ordinarios, por lo que deben aplicarse normas estrictas de responsabilidad, de forma similar a los primeros casos de aviación.17 Sigue siendo incierto qué estándares de responsabilidad se aplicarán realmente.

La pregunta urgente es cómo se abordará la responsabilidad a medida que la sociedad haga la transición a vehículos totalmente automatizados. Durante este período, los humanos y los distintos niveles de vehículos autónomos compartirán las carreteras y tendrán el deber de conducir de forma segura y razonable. Según los principios generales del derecho de daños, el elemento de control suele ser determinante. La cuestión de cuánto control tenía, o debería haber tenido, el conductor en el momento del accidente determinará si el conductor podría haber evitado el accidente.

Tradicionalmente, las colisiones de vehículos de motor se evalúan de acuerdo con la negligencia del conductor, con el potencial de responsabilidad del producto cuando un defecto en el automóvil causa el accidente o agrava las lesiones. Los pocos incidentes hasta la fecha casi todos involucraron acusaciones de negligencia, lo que sugiere que es poco probable un cambio total a la responsabilidad por productos. Esto parece especialmente cierto durante el largo período de tiempo durante el cual los vehículos manuales, semiautónomos y totalmente autónomos comparten la calzada.

Según los incidentes ocurridos hasta la fecha, en general parece haber tres vías de responsabilidad diferentes en los casos de AV: (1) teorías basadas en el producto; (2) teorías de la actividad corporativa; y (3) teorías basadas en la conducción.

Las teorías basadas en productos incluyen la responsabilidad "estricta" del producto (prueba de expectativas del consumidor, riesgo / utilidad, diseño alternativo razonable), garantías en forma de marketing u otras representaciones que prometen una seguridad razonable y responsabilidad estricta para el propietario del AV.

Las teorías de la actividad corporativa incluyen negligencia en el diseño de productos, deber de cuidado del transportista común, actividad ultrapeligrosa, negligencia de ingeniería, tergiversación y publicidad engañosa.

Las teorías basadas en la conducción incluyen acciones contra el conductor negligente y/o la empresa con control sobre el sistema de conducción automatizado en cuestión. Por el momento, anticipamos que los demandantes continuarán empleando un enfoque híbrido nombrando a múltiples demandados y múltiples acusaciones en litigios AV.

Anticipamos que las defensas del asegurador / fabricante incluirán: (1) la asignación de responsabilidad al conductor y / o la parte lesionada; (2) alegar que el accidente fue inevitable; (3) negar la existencia de un defecto; y (4) basarse en "estándares de la industria", ya que estos recién están comenzando a desarrollarse, no existe un marco regulatorio y gran parte de la tecnología está etiquetada como "secreto comercial".

VI. Dilemas éticos de AV

Los vehículos totalmente autónomos se convertirán en una realidad. También es probable que AV no elimine completamente las colisiones. Cuando se producen colisiones, sus resultados pueden estar predeterminados por los programadores y los responsables de la formulación de políticas.

Muchos dilemas éticos surgen al predeterminar el resultado de colisiones, que los abogados litigantes deben comprender. Por ejemplo, imagine que está conduciendo un AV en una carretera muy transitada rodeada de otros vehículos. De repente, un objeto grande cae del camión que está delante de usted. Su automóvil no puede detenerse a tiempo, por lo que toma una de tres decisiones: (1) seguir recto, frenar y golpear el objeto; (2) virar a la izquierda y chocar contra un vehículo; o (3) virar a la derecha y chocar contra una motocicleta.

¿Debería el AV priorizar su seguridad golpeando al motociclista? ¿Minimiza el daño yendo derecho y golpeando el objeto grande, incluso si eso significa maximizar el daño para ti? ¿O tomar el camino del medio y golpear el SUV a su izquierda que tiene una alta calificación de seguridad para los pasajeros?

Si un humano estuviera conduciendo, la reacción del humano se atribuiría precisamente a eso: una reacción. Sin embargo, con AV, no hay reacciones, solo toma de decisiones programada. Estas decisiones son el resultado de algoritmos que, por diseño, determinan la colisión más favorable. Es decir, el vehículo favorece sistemáticamente un determinado tipo de choque. Los pasajeros de esta decisión algorítmica sufrirán las consecuencias.

¿Debería haber fallas en la programación? Además, ¿quién debería tomar estas decisiones? ¿Ingenieros, juntas corporativas o legisladores? Mire este breve video de TedTalk para una discusión interesante sobre dilemas éticos con AV.18 VII. Conclusión Las víctimas de lesiones causadas por vehículos de motor se enfrentarán a problemas nuevos y desafiantes a medida que avance la tecnología AV. Sin duda, estos avances tecnológicos proporcionarán a las corporaciones y aseguradoras métodos nuevos y sofisticados para repartir culpas, evitar responsabilidades y negar a las víctimas de lesiones una reparación legal completa. Aquellos lesionados por vehículos autónomos necesitarán abogados familiarizados con los problemas para presentar sus reclamos. Los abogados también deberán trabajar con los legisladores para garantizar que los avances tecnológicos no anulen las garantías del Artículo II, Sección 16 de la Constitución de Montana.

NOTAS FINALES

- https://www.sae.org/news/ press-room/2018/12/sae-international- releases-updated-visual-chart-forits-% E2%80%9Clevels-of-drivingautomation% E2%80%9D-standard-forself- driving-vehicles

- https://www.nhtsa.gov/technologyinnovation/ automated-vehicles-safety

- https://www.tesla.com/blog/tragicloss

- https://www.ntsb.gov/investigations/ AccidentReports/Reports/ HAR1702.pdf

- Oscar Nilsson contra General Motors LLC, Caso 4:18-cv-00471-KAW, Tribunal de Distrito de los Estados Unidos, Distrito Norte de California (2018).

- Hudson contra Tesla, Inc., et al, Juzgado 9 del Tribunal de Circuito. Circuito, Florida (2018).

- https://www.nytimes. com/2018/03/19/technology/uberdriverless- fatality.html.

- https://www.documentcloud.org/ documents/6540547-629713.html

- Orden ejecutiva de Arizona 2015-09, "Prueba y pilotaje de vehículos autónomos en el estado de Arizona".

- Heather P. Lommatzsch contra Tesla, Inc., et al., Tribunal del Tercer Distrito para el Estado de Utah, Condado de Salt Lake (2018)

- https://www.reuters.com/article/ us-tesla-autopilot-lawsuit-idUSKCN1IQ1SH

- Szu Huang et al, contra Tesla, Inc., dba Tesla Motors Inc., et al, Caso No. 19-CV-346663, Tribunal Superior del Estado de California (2019).

- https://www.ntsb.gov/investigations/ AccidentReports/Reports/ HWY19FH008-preliminary.pdf

- Kim Banner, como representante personal del patrimonio de Jeremy Banner, contra Tesla Inc., et al., 15.º Circuito Judicial del condado de Palm Beach, Florida (2019).

- https://www.ncsl.org/research/ transportation/autonomous-vehiclesself- driving-vehicles-enacted-legislation. aspx

- Poner las riendas sobre la responsabilidad de los vehículos autónomos (North Carolina Journal of Law & Technology, vol. 19, diciembre de 2017)

- Adán Rosenberg. Responsabilidad estricta: imaginando un marco legal para vehículos autónomos. Adam Rosenberg, volumen 20, Tulane Journal of Technology (julio de 2017).

- https://www.ted.com/talks/patrick_ lin_the_ethical_dilemma_of_self_ driving_cars